Наблюдаем на страницу глазами Googelbot и контролируем синтаксис robots.txt. И поднимаемся в поиске!

Данный материал — продолжение статьи 20 фишек, как определить все про любой сайт. Сейчас обращение отправится о веб-сервисах, контролирующих изюминки сайтов/страниц, каковые воздействуют на их ранг в поисковой выдаче.

Для чего мне это необходимо?

В случае если у вас имеется сайт, но вы не интересуетесь поисковой оптимизацией, и у вас нет эксперта, что занимается его продвижением, то время от времени смогут появляться вопросы наподобие:

Из-за чего мой сайт ниже в поисковых выдаче, чем аналоги, не смотря на то, что уровень качества контента выше?

Вероятнее, на сайте имеется какие-то технические неприятности, серьёзные для поисковых машин (битые ссылки, неточности в html-коде).

Отыскать такие неприятности окажет помощь статья ниже.

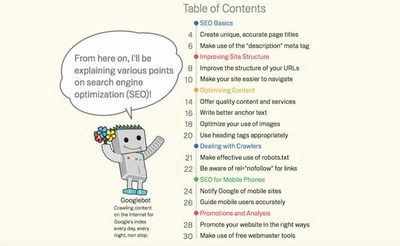

В сети имеется множество блогов с советами по SEO, многие из которых в далеком прошлом устарели либо изначально являлись фантазией автора. Занимаясь оптимизацией сайта, лучше ориентироваться на официальные гайдлайны для вебмастеров Search Engine Optimisation Starter Guide.

В том месте четко прописано, какие конкретно технические изюминки имеют настоящее влияние на поисковую выдачу.

В случае если сайт содержит качественную и нужную данные, и соответсвует требованиям, прописанных в этих гайдлайнах, то с ростом поискового трафика должно быть все ОК. А вот подборка инструментов, каковые окажут помощь скоро обнаружить сайте (собственном либо чужом) незаметные на первый взгляд нюансы, очень плохо воздействующие на отношение к нему поисковых машин.

1. Имеется ли «битые» ссылки?

Битые ссылки очень плохо воспринимаются пользователями, исходя из этого Гугл использует санкции к страницам с их громадным числом. На deadlinkchecker.com возможно взять полный перечень URL-адресов на странице и статусы их доступности.

Адрес сервиса: deadlinkchecker.com

2. Достаточно ли оптимизированы картины?

На wepagetest.org возможно взять перечень картин с указанием их размера и примененных способов сжатия для каждой картины. В том месте же возможно почитать советы по оптимизации изображений для сайтов.

Адрес сервиса: webpagetest.org

3. Корректно ли составлен файл robots.txt?

Robots.txt — это файл, в котором обладатель сайта показывает, какие конкретно разделы сайта индексировать поисковому роботу.

Крайне важно, дабы в нем не было неточностей, так при их наличия Гугл может проиндексировать лишние страницы.

alterlinks.com/robots-txt-validator/

4. Валиден ли HTML-код?

В случае если html-код не содержит неточностей, то страница будет скоро загружаться и одинаково отображаться во всех браузерах. Посредством валидатора от организации и3 (консорциума, которая регулирует технологические стандарты в сети) возможно отыскать неточности и взять советы по их исправлению.

Адрес сервиса: validator.w3.org

5. Нет ли перебора с главными словами?

Избыточная плотность главных слов время от времени может оказывать влияние на ранг в поисковой выдаче хуже, чем их отсутствие/недочёт.

На pr-cy.ru возможно проверить число вхождения слов на страницу.

Адрес сервиса: pr-cy.ru/analysis_content/

6. Имеется ли ссылки без анкоров и с атрибутом “nofollow”?

Анкор — это текст ссылки между тегами “” и ““. Гугл не хорошо относится к сайтам, каковые делают ссылки картинами, с безлюдными анкорами либо анкорами без смысловой нагрузки («просматривайте тут», «наблюдать тут»).

Кроме этого Гугл против указания в ссылках атрибута rel=”nofollow” (запрет роботы переходить на страницу), так как он мешает поисковику воплотить идею об индексации всего интернета. Подробнее об этом возможно почитать в гайдлайнах, упомянутых в начале статьи. А pr-cy.ru возможно проверить все ссылки на сайте на наличие анкоров и запретов на индексацию.

Адрес сервиса: pr-cy.ru/analysis_content/

7. Нет ли на сайте вирусов?

Найдя на сайте вредоносное ПО Гугл начинает ставить рядом с заголовком страницы надпись «Данный сайт может нанести вред вашему компьютеру», отбивая желание визитёров заходить на него. В случае если поисковый трафик неожиданно сократился на порядок, то одной из самых возможных обстоятельств возможно появление на сайте вредоносного контента.

Адрес сервиса: гугл.ru/transparencyreport/safebrowsing

8. Верно ли настроен редирект?

Время от времени, из-за таковой мелочи, как неправильно настроенное перенаправление с одной страницы (которая уже имеется в базе Гугл) на новую (которая до тех пор пока малоизвестна поисковому роботу), сайт может ощутимо утратить в трафике. Неизменно стоит контролировать данный момент.

Адрес сервиса: webconfs.com/redirect-check

9. Все ли в порядке с метатегами?

Тут возможно проверить указаны ли на странице описание и заголовок, и оценить соответствие главных слов ее содержимому.

Адрес сервиса: metatagscheck.com

10. Как видит текст страницы поисковый робот?

Гугл не индексирует текст, созданные посредством Flash, JavaScript и изображенный на картинах.

Данный сервис окажет помощь осознать какой текст на странице учитывается поисковиком при ранжировании результатов, а какой нет.

Адрес сервиса: smallseotools.com/spider-simulator/

11. В каком состоянии была страница в то время, когда на нее последний раз приходил Googlebot?

Тут возможно определить в то время, когда на странице последний раз был Googlebot и в каком виде она сохранена в кеше Google.

Адрес сервиса: smallseotools.com/google-cache-checker/

12. Какой уровень доверия Гугл к домену?

Чем выше уровень доверия к домену, тем выше ранг страниц, каковые на нем находятся.

Trust Rank зависит от возраста домена, его истории и т.д. На smallseotoolz.com возможно проверить данный показатель для любого ресурса.

Адрес сервиса: smallseotoolz.com/domain-authority-checker-tool

Все эти инструменты возможно попытаться не имея доступа к файлам сайта. В случае если данный доступ у вас имеется, то для проверки этих же параметров лучше применять Яндекс.Вебмастер либо Гугл Search Console.

Оптимизируя страницы для поисковых совокупностей, следуем не забывать о том, что главным критерием ранжирования являются поведенческие факторы: время совершённой пользователем на странице, его активность и т.д. Каким бы совершенным не был html-авторитетным домен и код, в случае если визитёры удирают с сайта через 10 секунд, то и поисковые машины не будут ценить ее высоко.

Кроме увеличения качества контента, для улучшения поведенческих факторов полезно следить за тем, как ведут себя пользователи на сайте. Делать это разрешает разработка «Вебвизор», встроенная в счетчики Яндекс.Метрики. «Вебвизор» записывает все действия пользователей (перемещения мыши, нажатия клавиш) и генерирует видео имитирующие их поведение на протяжении визита.

Наблюдение за визитёрами и забота об их удобстве, на порядок серьёзнее всех технических моментов, упомянутых в статье.

26 ноября 2015

26 ноября 2015  smart

smart  Рубрика:

Рубрика:  Метки:

Метки: